Che cos’è l’AI veganism e che ne sarà di noi

Una resistenza su valori, non su paura: l’AI veganism non è una moda, ma forse un manifesto.

LETTERATURA

by Martin J. Osburton

8/22/20253 min leggere

Siamo immersi nell’IA, miliardi di contenuti vengono immessi ogni giorno in rete, eppure qualcuno sceglie l’astensione: per etica, per ambiente, per cultura. InfoData racconta un astensionismo tecnologico praticato con convinzione, non con paura: la decisione — quasi paradossale — di chi farebbe da pioniere in ogni altro campo.

Contesto storico e analogia. Nei primi anni 2010 i social erano facoltativi: si poteva restarne fuori senza stigma. La curva classica dell’adozione (innovatori, early adopters, maggioranze, ritardatari) sembrava una legge. Oggi la stessa grammatica si applica all’IA, ma con una deviazione: alcuni “ritardatari” potrebbero restare tali per scelta, non per inerzia. E la pressione culturale non manca: il fondatore di un colosso social prevede uno “svantaggio cognitivo significativo” per chi non porterà occhiali intelligenti; un invito mascherato a conformarsi.

Cos'è l'"AI veganism". L'etichetta AI veganism definisce chi decide di astenersi dall'uso dell'IA, come un vegano evita prodotti animali. Non un ritardo nell'adozione tecnologica, ma una posizione etica consapevole. Il movimento, documentato in recenti studi accademici, nasce da preoccupazioni etiche legate al consenso dei creatori di contenuti usati per addestrare l'IA, dall'impatto ambientale dei data center, e da timori sugli effetti cognitivi dell'eccessiva dipendenza dall'intelligenza artificiale. In tre parole: principi prima dei processori.

Il concetto si è ampliato nel dibattito pubblico fino a includere, secondo alcuni commentatori, anche la preoccupazione teorica di non nuocere a eventuali future forme di sensibilità delle macchine — idea discussa e contestata, ma ormai nel lessico pubblico.

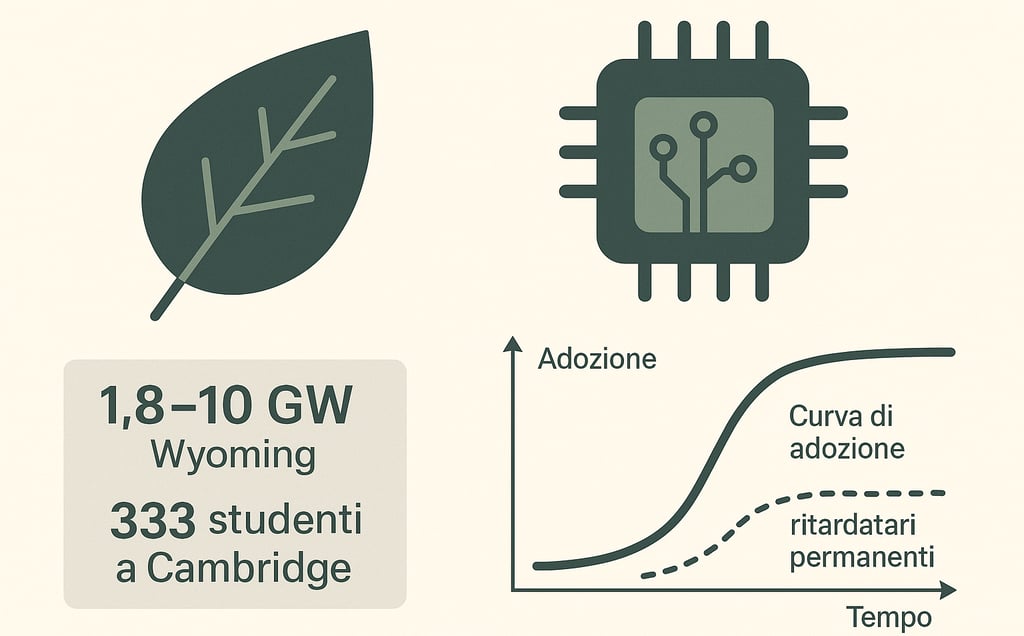

Il paradosso dei “ritardatari”. Non sono nostalgici luddisti a guidare il passo indietro. Spesso sono studenti e professionisti digitali in prima linea. Un sondaggio del 2025 condotto su oltre 330 studenti di Cambridge e pubblicato da Varsity racconta un dato interessante. Il 61,3% ha usato strumenti di Intelligenza Artificiale per i propri lavori accademici. Quasi il 30% li ha impiegati persino in compiti o esami valutati.

Le motivazioni non riguardano tanto la paura delle sanzioni universitarie, quanto piuttosto l’impatto ambientale e la sfiducia verso le Big Tech. In altre parole: non è un “no” alla tecnologia in sé, ma un rifiuto del sistema che la gestisce. Qui entra in gioco la cosiddetta algorithm aversion. Ci fidiamo più delle persone che degli algoritmi, e basta un singolo errore per abbandonare le macchine, anche se mediamente si rivelano più affidabili. Una tendenza che la ricerca documenta almeno dal 2014.

Ambiente, numeri e scala. Sul piano ambientale la discussione è concreta. Il MIT ha ricordato che lo sviluppo e l’uso dei modelli generativi aumentano domanda di elettricità e acqua lungo l’intera filiera (training, inferenza, data center).

I numeri del Wyoming rendono tangibile la scala: vicino a Cheyenne è in cantiere un data center che nella prima fase assorbirà 1,8 GW — più dell’elettricità di tutte le abitazioni dello Stato — con possibilità di scalare fino a 10 GW. Il progetto è firmato da Tallgrass e Crusoe; l’inquilino finale non è stato rivelato.

Gli ottimisti ribattono che, a livello individuale, un singolo prompt consuma poco, e hanno ragione se si guarda il gesto minimo. Ma InfoData ricorda che la scala — milioni di prompt, modelli sempre più grandi, infrastrutture dedicate — cambia il quadro. Qui la domanda non è ascetica, è civile: quale beneficio culturale giustifica questa spinta energetica? E chi decide la soglia di “necessario”?

Oltre l’adozione: bisogno di senso. Nel 2010 ignorare Facebook poteva sembrare eccentricità; oggi ignorare l’IA è un gesto politico, una presa di posizione: affermare che l’intelligenza — anche quella artificiale — va scelta, non subita. L’AI veganism offre un linguaggio a questo gesto minoritario ma nitido.

Il punto — mi correggo: il nocciolo — è che la tecnologia non fornisce da sola il senso. Quel senso va negoziato: con i creatori le cui opere finiscono nei dataset; con i cittadini che pagano le bollette; con chi teme l’erosione della capacità critica. Forse l’astensione non è negazione, ma pedagogia: ricordare alla tecnica i suoi limiti.

La vera provocazione è semplice: di quanta IA abbiamo davvero bisogno? Risposta breve: del necessario. Il resto — perdonate — è rumore di fondo.

Riflessioni

Uno spazio per pensare oltre la superficie.

Creatività

martin@osburton.com

+?? ??? ??????? - vuoi sapere il mio numero di telefono ? Clicca qui.

© 2025. Tutti i diritti sono riservati.